Dicen que más vale prevenir que curar, especialmente si se trata de la comisión de delitos. Una de las prioridades de las fuerzas y cuerpos de seguridad es anticiparse a posibles hechos delictivos con el objetivo de mantener el orden a nivel local y nacional. Esta tarea ha recaído históricamente sobre los analistas, sin embargo, desde finales de los años 90 y con el desarrollo del Big Data y la Inteligencia Artificial (IA), las fuerzas de seguridad han empezado a desarrollar programas y métodos informáticos capaces de predecir las circunstancias de la comisión de un determinado delito.

El termino técnico es el predictive policing, o análisis predictivo, es decir “el uso de técnicas de análisis, en particular técnicas cuantitativas, para identificar objetivos potenciales que requieren la intervención policial, además de prevenir delitos o resolver crímenes pasados mediante pronósticos estadísticos”, y se basa en el principio de repetición, según el cual los delincuentes tienden a desarrollar un comportamiento reiterativo cuando su metodología criminal resulta ser eficaz.

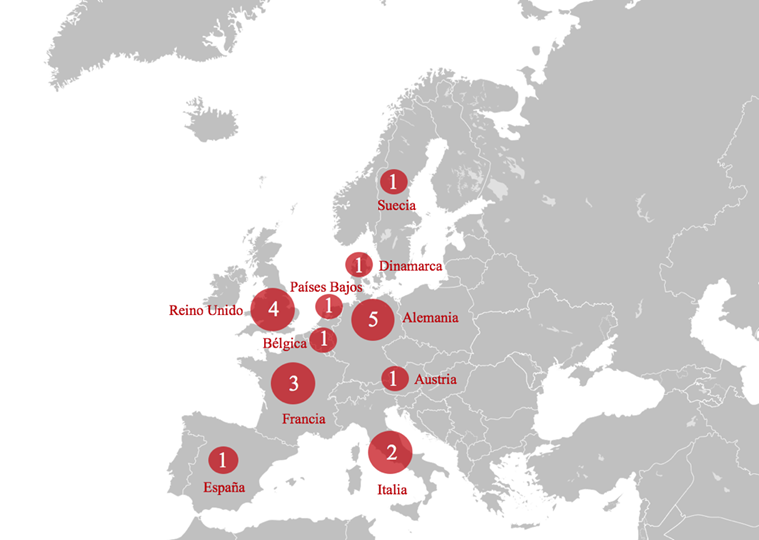

El país precursor de estas técnicas es Estados Unidos, mientras que en Europa fue Francia el que, en 1994, implementó el primer programa de análisis predictivo del continente denominado Anacrim. Hoy en día, 10 de los 28 estados miembros de la Unión Europea han adoptado alguna técnica de análisis predictivo, contabilizándose alrededor de veinte programas en funcionamiento.

En el caso de España, tanto la Guardia Civil como la Policía Nacional han mostrado interés en el fenómeno, si bien su desarrollo todavía se encuentra en una fase preliminar y ningún sistema operativo ha sido aplicado de manera permanente a nivel nacional o local.

El primer programa de análisis predictivo español, el EuroCop Pred-Crime, fue desarrollado en 2011 por la empresa EuroCop Security Systems en colaboración con la Universidad Jaume I de Castellón. Se trata de un modelo matemático que, utilizando múltiples fuentes de información (incluyendo expedientes policiales, datos socioeconómicos, urbanísticos y geográficos), genera mapas de calor con el fin de identificar las zonas más probables en donde puede tener lugar un delito. Dicho programa fue testado en 2016 en dos cuerpos de Policía Local: el de Castellón y el de Rivas Vaciamadrid.

En una línea similar se encuentra el sistema matemático Predictive Police Patroling (P3-DSS), el cual hace uso de un algoritmo para asignar a las unidades policiales un área de patrulla en base a un nivel de riesgo extraído del historial de los actos delictivos cometidos en ese territorio. El desarrollo de este modelo se basó en el procesamiento de datos estadísticos de la Policía Nacional sobre los crímenes perpetrados en el Distrito Centro de Madrid durante un periodo de tres años, permitiendo crear un mapa reflejando las zonas potencialmente más problemáticas y facilitar así una distribución efectiva de las patrullas durante los turnos. Dicho sistema está todavía en fase de estudio y no se ha desarrollado por el momento como un programa informático.

Por último, se tiene constancia de que Guardia Civil también ha desarrollado internamente un Sistema de Análisis y Explotación Estadístico (SAEX) permitiendo la creación de un gran repositorio central de datos. Sin embargo, se trata más de una mejora en la elaboración y recopilación de datos policiales que un programa de predicción de crímenes como tal.

En resumen, a España todavía le faltan pasos por recorrer en el ámbito del análisis predictivo, pero se nota que su implicación hacia esta tecnología va en aumento. Este fenómeno no solo ejemplifica un desarrollo tecnológico, sino que es síntoma de los nuevos retos que afronta el sector de la seguridad, demostrando que, tanto en España como en Europa, las fuerzas de seguridad son cada vez menos reactivas y más enfocadas en la prevención.